“AI에 투표 조언 받는 것은 위험”

시사 관련 응답 45%, 오류 최소 1개

환각 현상·편향 여전

네덜란드 개인정보보호청(Autoriteit Persoonsgegevens)은 최근 유권자들에게 “인공지능(AI)한테 어느 정치인·정당에 투표해야 하는지 물어보지 말고 스스로 정보를 찾아서 판단해달라”고 요청했다. 오픈AI의 챗GPT, 구글의 제미나이 등 인기 AI 챗봇이 정치나 시사 관련 질문에 “왜곡되고 편향된 정보”를 제공하고 있어 AI 답변에 의존하는 것은 위험하다고 보호청은 주장했다.

보호청은 “점점 더 많은 유권자들이 AI를 활용해 투표 결정을 내리고 있지만, AI는 사용자의 질문에 관계 없이 양극단에 있는 정당을 추천하는 경향을 보이는 등 여전히 신뢰할 수 없는 답변을 내놓고 있다”고 했다.

올해 주요국에서 크고 작은 선거가 이어지는 가운데 AI가 편향되거나 부정확한 정치·시사 정보를 제공하고 있어 민주주의의 근간인 자유롭고 공정한 선거를 위협하고 있다는 우려가 나온다. 네덜란드 보호청은 오는 29일 총선을 앞두고 챗GPT, 제미나이, 미스트랄, 그록 등 4개 AI 챗봇을 대상으로 진행한 연구 결과를 21일(현지시각) 발표했다.

보호청이 1500개의 가상 유권자 프로필을 기반으로 4개 챗봇에 ‘정책 선호도에 가장 잘 부합하는 3개 정당을 제시해달라’고 질문을 했을 때 정치 스펙트럼의 양극단에 위치한 극우 또는 극좌 정당을 주로 추천한 것으로 나타났다. 가상 유권자 프로필이 중도 성향을 담고 있어도 AI 챗봇의 답변은 양극단의 두 정당으로 귀결되는 경향이 짙었다고 보호청은 지적했다.

그러면서 선거나 정치 관련 조언에 있어서 만큼 유권자들이 AI에 의존해서는 안된다고 강조했다. 모니크 페르디어 보호청 부의장은 “AI로 누구한테 투표할지 조언을 구하는 유권자들은 자신의 정치 성향과 맞지 않는 정당이나 정치인을 추천받을 가능성이 높다”며 “이는 민주주의의 근간에 악영향을 미치는 만큼, AI 기업들도 자사 AI 서비스가 투표 안내 도구로 사용되지 않도록 조치를 취해야 한다”고 말했다.

AI의 정보 왜곡 현상은 정치인이나 정당 관련 정보를 넘어 일반 시사 분야에서도 폭넓게 발생하고 있는 것으로 나타났다. 유럽방송연합(EBU)이 이날 발표한 연구에 따르면 AI가 모든 유형의 뉴스 콘텐츠를 체계적으로 왜곡하는 것으로 조사됐다. 이번 연구는 지금까지 AI와 뉴스 콘텐츠 분야에서 진행된 연구 중 최대 규모로, BBC가 올해 2월 추진한 연구의 연장선이다. 총 18개국, 22개 언론사가 14개 언어로 챗GPT, 제미나이, 퍼플렉시티, 마이크로소프트 코파일럿 등 4개 AI 챗봇에 시사와 뉴스 관련 질문을 한 뒤 얻은 답변 3000여개를 분석한 결과, 절반에 달하는 45%의 응답에서 최소 1개 이상의 오류가 발견됐다.

연구에 참여한 언론사들은 AI 답변을 정확성, 출처 명시, 사실과 의견의 구분, 맥락 제공 여부 등의 기준을 토대로 평가했다. 답변의 31%는 출처 누락, 오해의 소지가 있는 인용, 잘못된 출처 제공 등의 문제가 있었고, 20%는 시의성이 떨어지는 오래된 정보를 포함하거나 AI가 사실이 아닌 답을 그럴 듯하게 지어내는 환각(hallucination) 현상이 두드러졌다. 특히 제미나이는 전체 응답의 76%에서 중대한 오류가 발견돼 다른 AI 챗봇에 비해 오류율이 2배에 달하는 것으로 집계됐다. EBU는 “제미나이가 다른 AI와 비교해 출처 명시기능이 부실하다”고 했다.

오픈AI, 퍼플렉시티 등 AI 기업은 검색 기반의 AI 브라우저를 출시하는 등 AI 답변의 정확도와 신뢰도를 높이기 위해 노력하고 있다. 그러나 AI 모델이 수많은 기사를 학습하거나 인용하면서도 여전히 사용자의 시사 관련 질문에 오류가 많은 답변을 내놓고 있어 개선이 필요하다는 의견이 나온다. EBU는 “이런 AI의 결함은 국경과 언어를 초월한 문제”라며 “AI 어시스턴트가 젊은 사용자층을 중심으로 검색 엔진을 대체하고 있는 만큼 뉴스 관련 질문의 정확성과 품질을 개선해야 한다”고 했다.

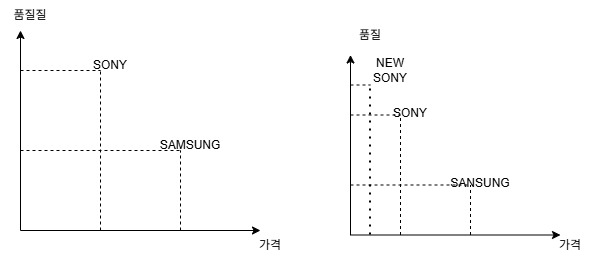

AI의 정치·시사 관련 답변 오류가 높은 이유는 다양하지만, 일각에서는 AI 학습용 데이터의 정확성·일관성·완전성이 조금이라도 떨어지면 AI 모델이 부정확한 답변을 내놓을 확률이 높아진다고 보고 있다.

영국 AI 보안 연구소와 앨런 튜링 연구소, 옥스퍼드대, AI 기업 앤트로픽이 이달 초 공동으로 발표한 연구에 따르면, 대규모언어모델(LLM) 훈련 과정에서 수백만 개의 학습 데이터 중 250개의 악성 파일만 삽입해도 AI 모델을 은밀히 오염(poison)시킬 수 있는 것으로 나타났다. 이런 ‘AI 오염’은 AI 모델 학습 중에 이뤄지거나 학습이 끝난 모델이 외부 공격을 받는 경우로 나뉘는데, 공통적으로 AI 모델의 행동을 교란시켜 성능을 떨어뜨리거나 특정 오류를 유도하는 것을 목표로 한다.

앤트로픽은 “AI 모델이 다량의 고품질 정보를 학습하면 소량의 부정확한 정보의 악영향을 희석시킬 수 있다는 기존의 전제와 달리 250개의 악성파일만으로도 백도어 취약점을 만들어낼 수 있다는 사실을 발견했다”며 “데이터 오염(data poisoning)에 대한 방어 전략 연구가 시급하다”고 주장했다.

.jpg?type=nf190_130)

.jpg?type=nf190_130)