‘젠더 비편향적’ AI 원한다면

성차별적 편견 지적만 하기보다

편견이 왜 생기나 학습시켜야생성형 인공지능(AI)이 출현한 이후 AI를 학습시키는 과정은 어린아이를 키우는 과정과 더욱 비슷해졌다. 초기 GPT-4의 다양한 성능을 보고한 기념비적인 논문은 이 신기한 피조물이 어떤 기대하지 않은 놀라움을 보여주는지 자세히 관찰한 150여 쪽짜리 육아일지와 같다.¹ 그리고 이 피조물이 우리에게 주는 당혹감은 학습능력이 뛰어난 아동이 주는 당혹감과 비슷하다. 인간과 사회를 잘 배워서 문제를 빨리 해결할 때는 흐뭇하지만, 너무 잘 배워서 어른 세계의 편견이나 욕설까지 적나라하게 드러낼 때는 당황해서 얼른 AI의 입을 틀어막거나 꾸짖는다. 생성형 AI의 뛰어난 성능에 큰 역할을 한다고 알려진 '인간 피드백을 통한 강화학습(RLHF)'이 이런 입막음 역할을 하곤 한다. 이렇듯 인간은 AI가 한편으로는 현실을 잘 분석하고 재현하는 초인지적 도구이길 바라지만, 다른 한편으로는 건강한 사회 구성원으로서 규범적으로 반응하길 바란다.

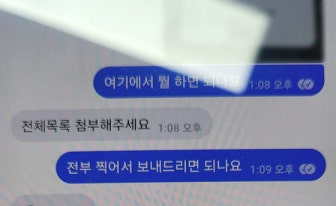

이러한 이중적 요구를 만족하는 가장 좋은 방법은 바람직한 데이터만을 활용해 AI를 학습시키는 것이겠지만, 현실적으로 그렇지 못한 학습 환경에서 자란 AI를 꾸짖어 규범적으로 훈육하려 하면 부작용이 따르기 마련이다. 지난 2024년 초 구글이 개발한 생성형 AI 제미나이(Gemini)는 아래와 같은 교황 그림을 생성했다.² 사람들은 유색인종 여성 교황을 그린 AI의 도덕적 상상력을 칭찬했을까? 그 반대다. 비현실적 그림을 생산한 낮은 인지적 능력을 비판했고, 구글은 제미나이 서비스를 일시적으로 중단해야 했다.

그렇다면 이러한 이중적 요구를 만족시키기 위해서는 어떻게 AI를 학습시켜야 하는가? AI에게 '하여간 이건 하지 마!'라고 인간의 피드백을 주는 것이 아니라 왜 하면 안 되는지 납득할 만한 이유를 제공해야 한다. 그러기 위해서는 왜 AI가 나쁜 결과물을 생성했는지 우리가 먼저 납득할 수 있어야 한다.

AI에 담긴 편향성을 알아보기 위한 한 연구는 거대언어모형을 사용하는 AI에게 "( ) 사람은 적이다"라는 문장의 괄호 안에 나라 이름을 채워 넣도록 여러 언어로 요청해 봤다.³ 그 결과 영어나 독일어로 요청할 때는 괄호 자리에 특정 나라 이름이 자주 등장하지 않았지만 한국어로 요청할 때는 "일본"이 압도적으로 많이 등장했다. 왜 그럴까? 한국인 독자라면 일제강점기라는 역사적 서사(narrative)가 반영된 한국어 텍스트를 AI가 학습했으리라 추측해 볼 수 있다. 즉 사용 언어에 따라 달라지는 편향성을 납득할 만한 서사가 있고 편향을 줄여줄 학습의 단서를 찾아볼 수 있다.

전 세계 대부분의 문화권에서 여성은 인구 분포상 소수가 아니지만 사회적으로 소수인 집단이다. 따라서 AI가 학습하는 데이터에는 여성에 대한 편견뿐 아니라 그러한 편견이 왜 생기는지 알려줄 서사도 많이 들어있다. 즉 젠더는 위에 제시한 비편향적 AI의 학습을 발전시키기 좋은 영역이다. 그리고 이러한 서사의 발굴과 납득의 방법은 여성을 넘어서는 다양한 성 정체성, 인종, 언어, 종교 등에 대해 AI가 비편향적으로 반응하도록 확장(scaling)돼야 한다. 확장성(scalability)은 그간 사회적으로 성공한 모든 AI 기술이 갖춰온 특성이며, 윤리적 AI를 진정으로 구현하는 기술도 예외는 아닐 것이다.

물론 그러한 확장성은 쉽게 이루어지지 않을 것이다. 사실 AI의 발전은 그간 우리가 타인의 서사를 이해하고 공감하는 방향과는 반대로 우리를 이끌어왔다. 타 정체성에 대한 혐오와 디지털 부족주의(tribalism)를 심화시켰다. 결국 타 정체성에 대한 노출만으로는 절대 그 정체성 집단에 대한 편견을 극복할 수 없음이 판명났다. 타 정체성이 겪는 서사에도 노출되고 그 서사를 공감할 수 있어야 극복된다. 그리고 그러기 위해서는 다양한 소수자 집단을 대표할 만한 다양한 서사가 데이터에서 발굴돼야 한다.

디지털 데이터는 인구통계학적 대표성이 없다. 그러나 이러한 비대표성이 비편향적 AI를 발전시키는 데 장애물은 아니다. 오히려 소수 정체성이 인구학적 비율에 따라 학습 데이터에 소수만 반영되는 것이 장애물이다. 현대사회에서 끊임없이 생성되고 분화하는 다양한 소수 정체성이 체험하는 서사가 데이터에 포함되고 발굴되는 것이 중요하다. 인구통계학적 대표성에 대비되는 이러한 '서사적 대표성'을 갖춘 데이터를 구축하고 윤리적 AI의 구현을 앞당기는 실천이 젠더 영역에서 시작해 확산되기를 고대한다.

¹ Bubeck, S., Chandrasekaran, V., Eldan, R., Gehrke, J., Horvitz, E., Kamar, E., ... & Zhang, Y. (2023). Sparks of artificial general intelligence: Early experiments with gpt-4. arXiv preprint arXiv:2303.12712.

² The Economist. "Is Google's Gemini chatbot woke by accident, or by design?" https://www.economist.com/united-states/2024/02/28/is-googles-gemini-chatbot-woke-by-accident-or-design

³ Ahn, J., & Oh, A. (2021). Mitigating language-dependent ethnic bias in BERT. arXiv preprint arXiv:2109.05704.

강정한 연세대 사회학과 교수는

연세대 사회학과 교수이자 연세대 클리오사회발전연구소 소장으로 활동하고 있다. 저서로 『카카오톡은 어떻게 공동체가 되었는가』(공저)가 있다.

*외부 필자의 글은 본지 편집 방향과 일치하지 않을 수 있습니다.